[ML] 2-2. 모델 선택 - 교차 검증

교차 검증

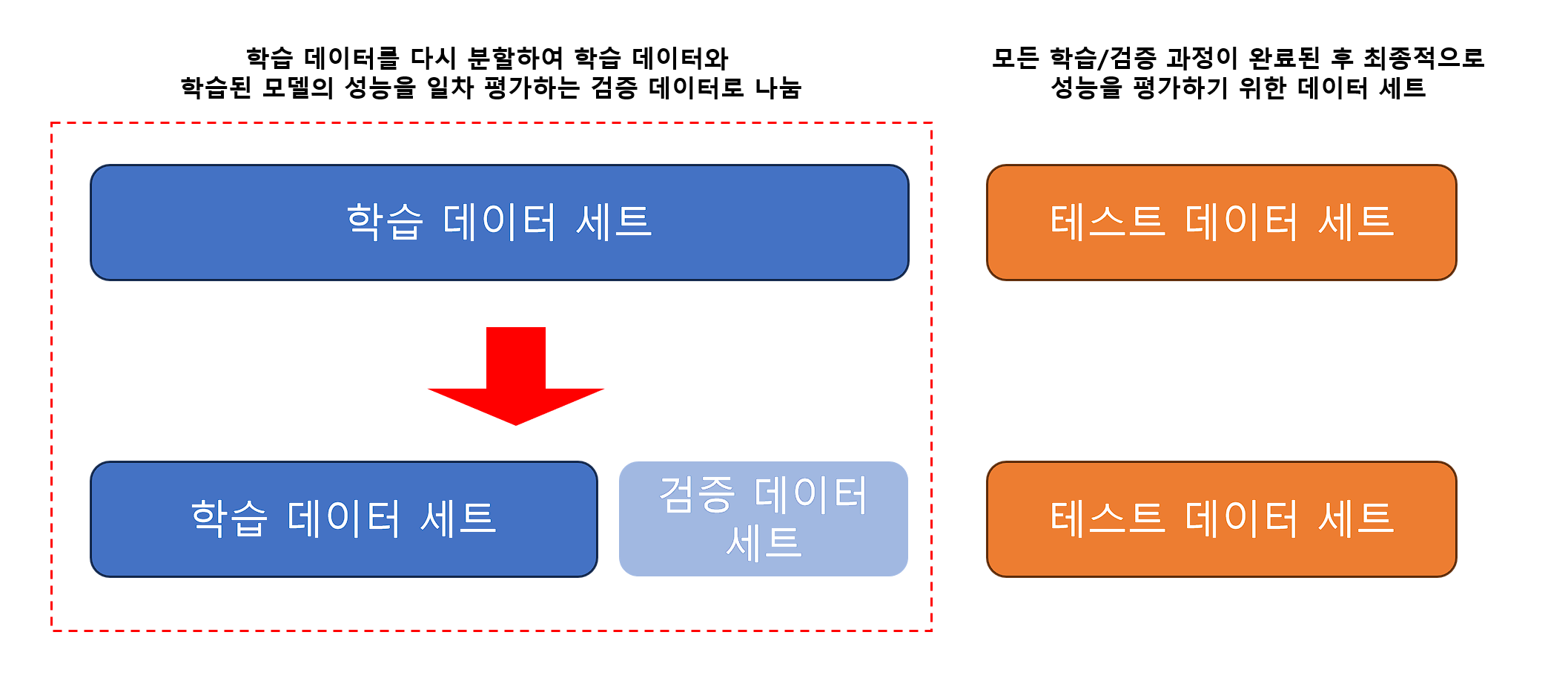

데이터 편중을 막기 위해 별도의 여러 세트로 구성된 학습 데이터 세트와 검증 데이터 세트에서 학습과 평가를 수행하는 것

K 폴드 교차 검증

K개의 데이터 폴드 세트를 만들어서 K번만큼 각 폴드 세트에 학습과 검증 평가를 반복적으로 수행하는 방법

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score

from sklearn.model_selection import KFold

from sklearn.datasets import load_iris

import numpy as np

iris = load_iris()

features = iris.data

label = iris.target

dt_clf = DecisionTreeClassifier(random_state=156)

# 5개의 폴드 세트로 분리하는 KFold 객체와 폴드 세트별 정확도를 담을 리스트 객체 생성.

kfold = KFold(n_splits=5)

cv_accuracy = []

print('붓꽃 데이터 세트 크기:', features.shape[0])

붓꽃 데이터 세트 크기: 150

n_iter = 0

# KFold 객체의 split()를 호출하면 폴드 별 학습용, 검증용 테스트의 로우 인덱스를 array로 반환

for train_index, test_index, in kfold.split(features):

# kfold.split()으로 반환된 인덱스를 이용해 학습용, 검증용 테스트 데이터 추출

X_train, X_test = features[train_index], features[test_index]

y_train, y_test = label[train_index], label[test_index]

# 학습 및 예측

dt_clf.fit(X_train, y_train)

pred = dt_clf.predict(X_test)

n_iter += 1

# 반복 시마다 정확도 측정

accuracy = np.round(accuracy_score(y_test, pred), 4)

train_size = X_train.shape[0]

test_size = X_test.shape[0]

print('\n#{0} 교체 검증 정확도 : {1}, 학습 데이터 크기 : {2}, 검증 데이터 크기 : {3}'

.format(n_iter, accuracy, train_size, test_size))

print('#{0} 검증 세트 인덱스 : {1}'.format(n_iter, test_index))

cv_accuracy.append(accuracy)

# 개별 iteration별 정확도를 합하여 평균 정확도 계산

print('\n## 평균 검증 정확도:', np.mean(cv_accuracy))

#1 교체 검증 정확도 : 1.0, 학습 데이터 크기 : 120, 검증 데이터 크기 : 30

#1 검증 세트 인덱스 : [ 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23

24 25 26 27 28 29]

#2 교체 검증 정확도 : 0.9667, 학습 데이터 크기 : 120, 검증 데이터 크기 : 30

#2 검증 세트 인덱스 : [30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53

54 55 56 57 58 59]

#3 교체 검증 정확도 : 0.8667, 학습 데이터 크기 : 120, 검증 데이터 크기 : 30

#3 검증 세트 인덱스 : [60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83

84 85 86 87 88 89]

#4 교체 검증 정확도 : 0.9333, 학습 데이터 크기 : 120, 검증 데이터 크기 : 30

#4 검증 세트 인덱스 : [ 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107

108 109 110 111 112 113 114 115 116 117 118 119]

#5 교체 검증 정확도 : 0.7333, 학습 데이터 크기 : 120, 검증 데이터 크기 : 30

#5 검증 세트 인덱스 : [120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137

138 139 140 141 142 143 144 145 146 147 148 149]

## 평균 검증 정확도: 0.9

Stratified K 폴드

불균형한 분포도를 가진 레이블 데이터 집합을 위한 K 폴드 방식 (ex. 대출 사기 데이터)

원본 데이터의 레이블 분포를 먼저 고려한 뒤 이 분포를 동일하게 학습과 검증 데이트 세트를 분배

일반적으로 분류에서의 교차 검증은 Stratified KFold를 이용하고, 회귀에서는 KFold로 진행 (회귀의 결정값은 이산값 형태가 아니기 때문)

from sklearn.model_selection import StratifiedKFold

import pandas as pd

iris = load_iris()

iris_df = pd.DataFrame(data=iris.data, columns=iris.feature_names)

iris_df['label'] = iris.target

iris_df['label'].value_counts()

0 50

1 50

2 50

Name: label, dtype: int64

skf = StratifiedKFold(n_splits=3)

n_iter = 0

for train_index, test_index in skf.split(iris_df, iris_df['label']):

n_iter += 1

label_train = iris_df['label'].iloc[train_index]

label_test = iris_df['label'].iloc[test_index]

print('## 교차 검증 : {0}'.format(n_iter))

print('학습 레이블 데이터 분포 : \n', label_train.value_counts())

print('검증 레이블 데이터 분포 : \n', label_test.value_counts())

## 교차 검증 : 1

학습 레이블 데이터 분포 :

2 34

0 33

1 33

Name: label, dtype: int64

검증 레이블 데이터 분포 :

0 17

1 17

2 16

Name: label, dtype: int64

## 교차 검증 : 2

학습 레이블 데이터 분포 :

1 34

0 33

2 33

Name: label, dtype: int64

검증 레이블 데이터 분포 :

0 17

2 17

1 16

Name: label, dtype: int64

## 교차 검증 : 3

학습 레이블 데이터 분포 :

0 34

1 33

2 33

Name: label, dtype: int64

검증 레이블 데이터 분포 :

1 17

2 17

0 16

Name: label, dtype: int64

dt_clf = DecisionTreeClassifier(random_state=156)

skfold = StratifiedKFold(n_splits=3)

n_iter = 0

cv_accuracy = []

# StratifiedKFold의 split() 호출 시 반드시 레이블 데이터 세트도 추가 입력 필요

for train_index, test_index, in skfold.split(features, label):

# split()으로 반환된 인덱스를 이용해 학습용, 검증용 테스트 데이터 추출

X_train, X_test = features[train_index], features[test_index]

y_train, y_test = label[train_index], label[test_index]

# 학습 및 예측

dt_clf.fit(X_train, y_train)

pred = dt_clf.predict(X_test)

# 반복 시마다 정확도 측정

n_iter += 1

accuracy = np.round(accuracy_score(y_test, pred), 4)

train_size = X_train.shape[0]

test_size = X_test.shape[0]

print('\n{0} 교차 검증 정확도 : {1}, 학습 데이터 크기 : {2}, 검증 데이터 크기 : {3}'

.format(n_iter, accuracy, train_size, test_size))

print('#{0} 검증 세트 인덱스 : {1}'.format(n_iter, test_index))

cv_accuracy.append(accuracy)

# 교차 검증별 정확도 및 평균 정확도 계산

print('\n## 교차 검증별 정확도 : ', np.round(cv_accuracy, 4))

print('## 평균 검증 정확도 : ', np.mean(cv_accuracy))

1 교차 검증 정확도 : 0.98, 학습 데이터 크기 : 100, 검증 데이터 크기 : 50

#1 검증 세트 인덱스 : [ 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 50

51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 100 101

102 103 104 105 106 107 108 109 110 111 112 113 114 115]

## 교차 검증별 정확도 : [0.98]

## 평균 검증 정확도 : 0.98

2 교차 검증 정확도 : 0.94, 학습 데이터 크기 : 100, 검증 데이터 크기 : 50

#2 검증 세트 인덱스 : [ 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 67

68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 116 117 118

119 120 121 122 123 124 125 126 127 128 129 130 131 132]

## 교차 검증별 정확도 : [0.98 0.94]

## 평균 검증 정확도 : 0.96

3 교차 검증 정확도 : 0.98, 학습 데이터 크기 : 100, 검증 데이터 크기 : 50

#3 검증 세트 인덱스 : [ 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 83 84

85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 133 134 135

136 137 138 139 140 141 142 143 144 145 146 147 148 149]

## 교차 검증별 정확도 : [0.98 0.94 0.98]

## 평균 검증 정확도 : 0.9666666666666667

cross_val_score() - 교차 검증을 간편하게

아래의 과정을 한꺼번에 수행해주는 API, 분류일 경우 Stratified KFold, 회귀일 경우 KFold 방식으로 자동 수행

- 폴드 세트를 설정

- for 루프에서 반복으로 학습 및 테스트 데이터의 인덱스를 추출

- 반복적으로 학습과 예측을 수행하고 예측 성능을 반환

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import cross_val_score, cross_validate

from sklearn.datasets import load_iris

iris_data = load_iris()

dt_clf = DecisionTreeClassifier(random_state=156)

data = iris_data.data

label = iris_data.target

# 성능 지표는 정확도(accuracy), 교차 검증 세트는 3개

scores = cross_val_score(dt_clf, data, label, scoring='accuracy', cv=3)

print('교차 검증별 정확도 : ', np.round(scores, 4))

print('평균 검증 정확도 : ', np.round(np.mean(scores), 4))

교차 검증별 정확도 : [0.98 0.94 0.98]

평균 검증 정확도 : 0.9667

Comments